荣格工业资源APP

了解工业圈,从荣格工业资源APP开始。

图片来源 / pixabay

来源 / nextplatform;荣格电子芯片翻译

作者 / Timothy Prickett Morgan

如果说地球上有什么市场迫切需要激烈的竞争,那就是正在推动人工智能革命的数据中心GPU市场。Nvidia几乎拥有它。

但随着时间的推移,AMD的Instinct GPU加速器越来越有竞争力,随着今天推出的Instinct MI325X和MI355X, AMD可以在GPU层面与英伟达的“Hopper”H200和“Blackwell”B100正面交锋。

但正如AMD所深知的那样,人们购买的是带有互连、系统软件、人工智能框架以及GPU加速器的系统,而在这方面,英伟达在许多方面仍具有决定性的优势。但话又说回来,如果你不能得到Nvidia的GPU——就像许多公司一样——那么AMD的GPU将比坐在GenAI繁荣的边缘要好得多。此外,AMD正在通过其ROCm堆栈赶上CUDA,并与UALink合作伙伴计划推出一种连贯内存互连,可以与英伟达的专有NVLink和NVSwitch结构竞争,从而实现机架级甚至行级系统。

但在10月10日旧金山举行的先进人工智能活动上,关于MI325X和MI355X的更多细节的公布以及未来MI400的暗示可能是讨论的最重要的事情。每个人都希望GPU加速器具有更广泛的混合精度和更多的HBM内存容量和带宽。

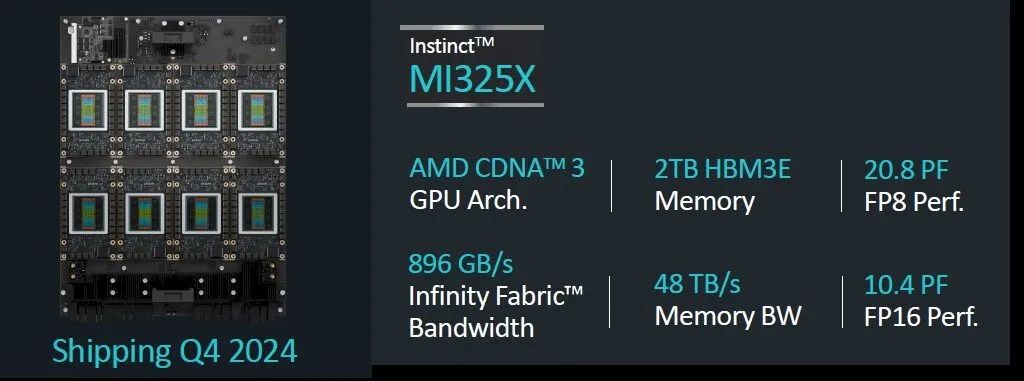

让我们从 MI325X 开始,它的速度和馈送与 6月份在台湾 Computex 贸易展上向我们展示的速度和馈送略有不同。

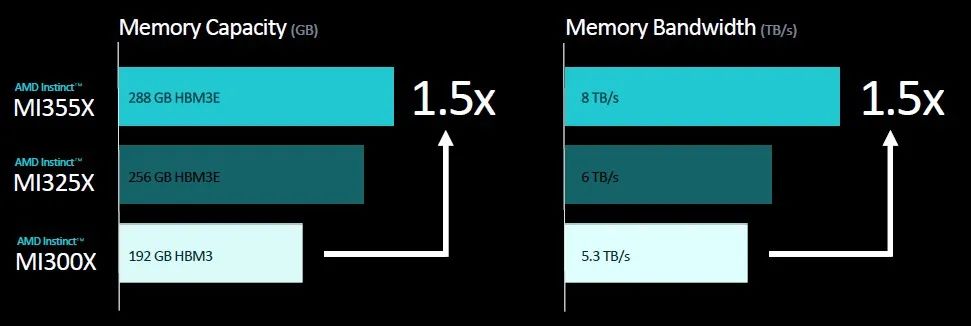

上面显示的速度图表表明,MI325X复体有1530亿个晶体管,这是一个封装中晶体管的巨大数量。浮点运算性能在FP16半精度下为1,307.4万亿次浮点运算,在FP8四分之一精度下为2,614.9千万亿次浮点运算,与四个月前的广告完全一致。然而,MI325X的内存容量有点小。最初,AMD表示,预计这8层HBM3E内存将达到288 GB,但由于某种原因(可能与12层3GB内存堆栈的产量有关),它只有256 GB。内存带宽与6月份宣布的相同,在这8个HBM3E堆栈中达到6tb /秒。

MI325X具有与现有的“Antares”MI300X GPU相同的性能,事实上,MI325是相同的计算复杂,在中国台湾半导体制造公司相同的4纳米工艺中蚀刻,其功率从750瓦提高到1000瓦,以便能够驱动更多的HBM内存容量和更高的带宽。

MI300X拥有192 GB稍慢的HBM3内存,封装上的总带宽为5.3 TB/秒。据我们所知,位于GPU块和HBM3或HBM3E内存之间的256 MB无限缓存是相同的。

MI325X plus与MI300X一样,采用相同的插座和开放计算通用基板服务器平台,因此无需创建新的服务器设计来容纳这些MI325X。当然,你必须有热容量来冷却它们。

以下是使用MI325X的八路GPU节点的馈送和速度:

每个MI300系列GPU都有7条128 GB/秒的Infinity Fabric链路,这使得它们可以在节点内部以全对全的共享内存配置连接。

AMD首席执行官Lisa Su在发布会上表示,MI325X将于本季度末开始出货,并将于明年第一季度在合作伙伴产品中投入使用。这差不多也是英伟达推出Blackwell B100 GPU的时候。

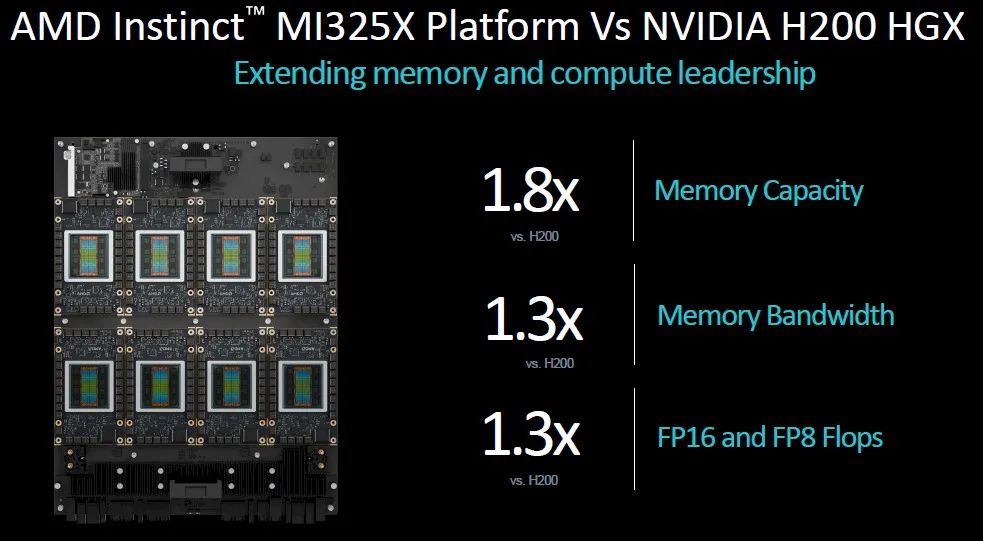

但目前,AMD满足于将MI325X与大内存的Hopper H200 GPU进行比较,后者的HBM3E内存为141GB,6个堆栈的带宽为4.8 TB/秒。在这里,AMD在GPU内存容量上有1.8倍的优势,这意味着加载特定模型的参数需要1.8倍的GPU,而在带宽上有1.25倍的优势,这意味着将这些参数提供给GPU所需的时间更少。(考虑人工智能训练性能中内存容量与带宽的比例是很有趣的,但我们现在没有时间做这个. . . .)

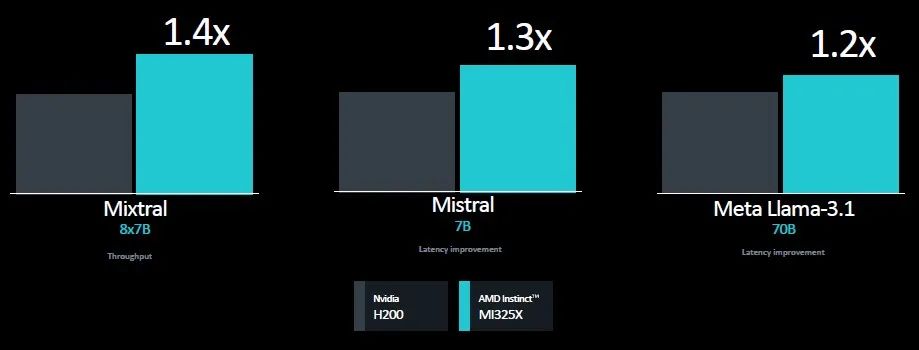

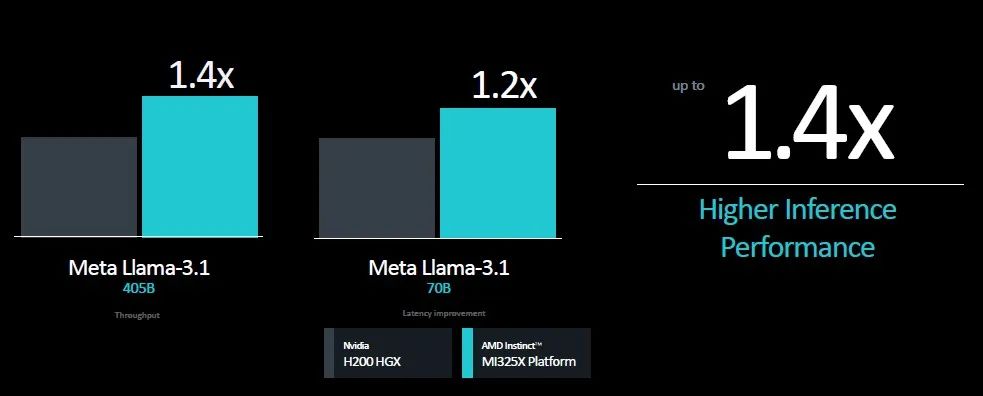

以下是苏在发布会上展示的Mi325X和H200的基准测试:

在这三个推理测试中,看起来性能主要是由MI325X和H200之间的带宽差异驱动的,这里和那里有一些波动。上图左侧显示的Mixtral基准测试测量的是推理吞吐量,其中内存容量可能更重要,Mistral和Llama 3.1测试测量的是推理延迟,这似乎是由HBM带宽驱动的。

在8个GPU平台上,所有这些优势都按比例扩大:

以下是 Llama3.1基准测试的一些性能规格,其中包含700亿个和4050亿个参数,可以证明这一点:

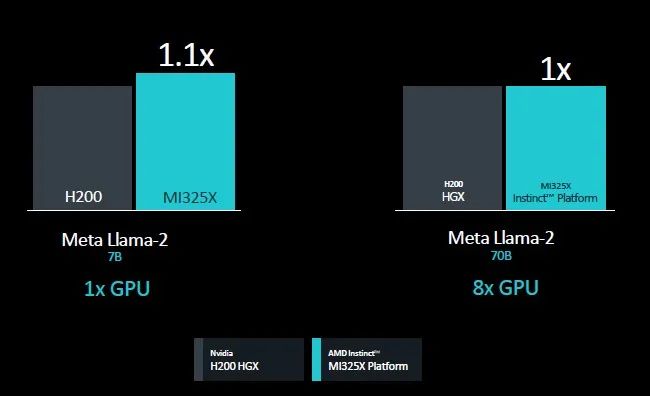

我们一直在等待看到一些人工智能训练的基准,AMD终于给了我们两个数据点,使用Meta平台的旧Llama 2模型:

有趣的一点是,当使用单个设备时,MI325X比H200有10%的性能优势,但当移动到8路GPU节点时,这种优势就消失了。我们猜测,与Nvidia HGX机器中使用的NVSwitch互连相比,Infinity Fabric的速度还不够快。但在性能方面,也许NVSwitch和那些在H200 HGX复合体中庞大的900GB /秒NVLink管道并没有我们想象的那么有帮助。至少对于 Llama2的推论是这样的。

AMD的 Llama3.1训练数据在哪里?这才是现在最重要的。

与此同时,我们将转向本能MI350系列GPU,这将是一个产品系列,其中第一个,我们今天了解到,将是MI355X。

MI350系列将实现CDNA 4架构,该架构可能来自预计将于2026年推出的未来MI400系列数据中心GPU。MI350系列将采用台积电的3纳米工艺蚀刻,并且可能在一个插座中有8个芯片。(如果是10个,那就太高太瘦了,除非你把小晶片做成矩形。)

早在6月份就透露,MI350系列将是AMD首款支持FP4和FP6浮点数据格式的GPU,它们将拥有288 GB的HBM3E内存,使用12个3GB的高堆栈。它将为HBM3E内存提供8tb /秒的带宽,大概将分为8个堆栈。

无论CDNA 4架构如何,MI355X插座的性能将是MI325X的1.8倍,即在FP16精度下每秒2.3千万亿次浮点运算,在FP8精度下每秒4.6千万亿次浮点运算,在FP6或FP4精度下每秒9.2千万亿次浮点运算。(这还不包括稀疏矩阵支持,如果没有密集的矩阵进行数学运算,这将使吞吐量提高两倍。)

这就引出了MI355X是否会比MI325X内存不足的问题。如果MI325X在288 GB和6 TB/sec的计算与内存比率方面是平衡的,那么我们预计MI355X将拥有512 GB的HBM3E内存容量和14.4 TB/sec的内存带宽。我想我们都同意这将是一个很棒的设备。

无论如何,以下是MI355X八路系统板的馈电和速度:

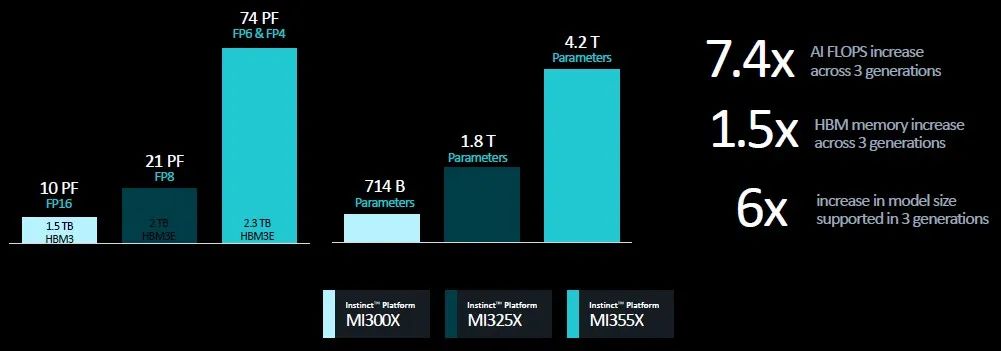

这张图显示了MI300X、MI325X和MI355X的八路系统板是如何跨越性能范围和参数大小的:

还记得5000亿个参数听起来很多吗?现在,数万亿似乎没什么大不了的。

看看MI400系列中使用的 CDNA-Next架构是什么样子,以及AMD使用了什么样的疯狂封装来将更多的东西塞进插座,这将是一件有趣的事情。我们也很想看到AMD正在做的产能规划,试图从绿色巨人那里抢走更多的业务。一切都由HBM可用性决定。

原文链接:

https://www.nextplatform.com/2024/10/10/amd-gives-nvidia-some-serious-heat-in-gpu-compute/

*声明:本文系原作者创作。文章内容系其个人观点,我方转载仅为分享与讨论,不代表我方赞成或认同,如有异议,请联系后台。